I casi accertati per ora sono due e tutti nell’ultimo mese. Sono stati smascherati, ma la preoccupazione che in futuro l’intelligenza artificiale possa interferire con la democrazia rimane viva.

Stiamo parlando dei deep fake, video o audio realizzati con l’intelligenza artificiale che riproducono immagini e suoni di persone realmente esistenti a cui si fanno dire o fare cose che non sono realmente accadute, con l’ovvia conseguenza che ciò potrebbe modificare la nostra percezione e la nostra opinione sugli ignari protagonisti.

Deep fake e intelligenza artificiale come arma politica? I casi nelle campagne elettorali

Dopo lo scandalo dei dati Facebook-Cambridge Analytica del 2018, quando fu rivelato che Cambridge Analytica aveva raccolto i dati personali di 87 milioni di account Facebook senza il loro consenso e li aveva usati per scopi di propaganda politica, ecco riaffiorare l’utilizzo delle tecnologie digitali nelle campagne elettorali.

Questa volta non c’entrano la profilazione e la privacy degli elettori, ma lo strumento utilizzato, i deep fake, potenzialmente potrebbe comunque orientarne l’opinione e condizionarne il voto.

Non si tratta di un pericolo astratto, ma di qualcosa che si è già verificato in due diversi Paesi europei, la Slovacchia e la Gran Bretagna.

Il primo caso risale al 29 settembre scorso quando, a 48 ore dalle elezioni in Slovacchia, in pieno silenzio elettorale, su Facebook inizia circolare un video deep fake in cui si sente Michal Šimečka, leader del partito liberale Slovacchia Progressista, raccontare come intende truccare le elezioni. I risultati del voto consacrano l’avversario di Šimečka, il filorusso Robert Fico.

Ieri, invece, l’Ansa ha riportato quanto accaduto in Gran Bretagna, dove il leader del partito laburista Keir Starmer stava lanciando la campagna elettorale per le elezioni che si svolgeranno alla fine del prossimo anno. Per la prima volta dopo molto tempo il Labour Party è in vantaggio di 20 punti sui Tories. È in quei momenti che su X, l’ex Twitter, inizia a circolare un audio, rivelatosi poi un deep fake, in cui si sente Starmer imprecare contro il suo staff.

Qualcosa di simile, ma senza l’utilizzo dell’intelligenza artificiale e con un chiaro intento satirico, era stato realizzato in Italia diversi anni fa quando, con un taglia e incolla, qualcuno aveva realizzato un discorso in cui Silvio Berlusconi affermava che «Il comunismo è il paradiso in terra». Parole assai lontane dal pensiero politico del leader di Forza Italia, che non hanno tratto in inganno nessuno.

I deep fake, invece, sono assai più sofisticati e nei video o negli audio non si avvertono tagli, ma il timbro e la tonalità delle voci dei protagonisti, così come la loro immagine, è uguale in tutto e per tutto all’originale.

ASCOLTA L’AUDIO FAKE DI BERLUSCONI:

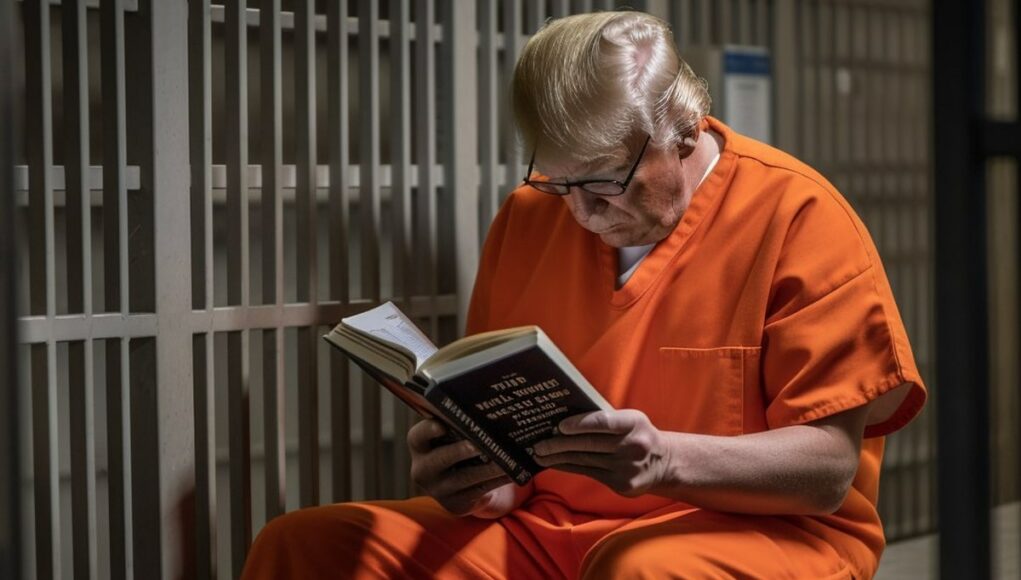

L’utilizzo dei deep fake è già ampiamente diffuso e non riguarda solo nelle campagne elettorali. Ad essere stati oggetto di immagini e video del tutto indistinguibili da quelle reali sono stati, tra gli altri, Papa Francesco (ritratto con abbigliamento costoso e poco consono per la tradizione dei pontefici) e Donald Trump (ritratto durante l’arresto o con la divisa arancione dei carcerati, come nell’immagine di copertina di questo articolo).

L’effetto di spaesamento per i cittadini è il medesimo, perché la definizione dell’immagine rende impossibile a occhio nudo comprendere che si tratta di falsi. Nei casi di Slovacchia e Gran Bretagna, però, l’aggravante è rappresentata dal pericolo di orientamento dell’opinione pubblica in processi democratici.

A raccontare i casi recenti di deep fake utilizzati in politica è stato Alessio Jacona, giornalista e curatore dell’Osservatorio sull’Intelligenza Artificiale dell’Ansa.

«Quando ho appreso la notizia quei contenuti avevano 700mila visualizzazioni, mentre quando ne ho scritto ne avevano 1,5 milioni – osserva Jacona ai nostri microfoni – Significa che girano velocemente e senza nessun controllo».

Eppure, gli strumenti dell’intelligenza artificiale generativa sono nati con un intento nobile, sottolinea il giornalista, come ridare la voce ha chi l’ha persa per un incidente o una malattia. Tuttavia ciò non impedisce che ad utilizzarli siano anche persone con intenti malevoli.

Il problema che Jacona evidenzia è che i tempi della tecnologia e della sua diffusione non coincidono con quelli amministrativi e legislativi che cercano di regolamentarla. «È come tentare di fermare le onde con le mani», sottolinea il curatore dell’Osservatorio dell’Ansa.

Al momento, quindi, l’unica arma a disposizione per impedire che un utilizzo fraudolento dell’intelligenza artificiale inquini l’informazione e di conseguenza la democrazia è la necessità che cresca la cultura tra la cittadinanza di come funzionano questi strumenti e la necessità di verificare le fonti.

ASCOLTA L’INTERVISTA AD ALESSIO JACONA: